一步到位:Hadoop 环境搭建与 JDK 安装详细指南

温馨提示:

本文最后更新于 2025年07月20日,已超过 200 天没有更新。若文章内的图片失效(无法正常加载),请留言反馈或直接联系我。

前言

对于刚接触大数据的学生初学者来说,第一步就是在本地搭建一个可运行的 Hadoop 单机环境。本文将从零开始,带你一步步安装 JDK、配置环境变量、下载并配置 Hadoop,最终完成单机伪分布式集群的搭建。

前提准备

- 操作系统:Ubuntu 20.04 或者 CentOS 7/8

- 硬件配置:至少 4 GB 内存,20 GB 可用磁盘空间

- 网络连接:可访问外网,以便下载 JDK 和 Hadoop

- 必要软件:SSH 客户端(Linux 通常预装)

提示:

- Hadoop 强依赖 Java 运行时环境,Java 版本可参考官方推荐清单。([hadoop.apache.org][1])

- 若使用 CentOS,请确保关闭或配置防火墙以允许 SSH 和 Hadoop 默认端口(9870、8088 等)。

安装 JDK

下载 JDK

前往 Oracle 官网或 OpenJDK 社区下载 JDK 8/11/17 安装包:https://www.oracle.com/java/technologies/javase-downloads.html上传并解压

# 以 JDK11 为例 wget https://download.oracle.com/otn/java/jdk/11.0.19+7/jdk-11.0.19_linux-x64_bin.tar.gz sudo mkdir -p /opt/jdk sudo tar -zxvf jdk-11.0.19_linux-x64_bin.tar.gz -C /opt/jdk/查看解压结果

ls /opt/jdk

配置环境变量

编辑系统 profile 以全局生效:

sudo tee /etc/profile.d/java.sh <<-'EOF'

export JAVA_HOME=/opt/jdk/jdk-11.0.19

export PATH=$JAVA_HOME/bin:$PATH

EOF

# 使配置生效

source /etc/profile.d/java.sh

验证 Java 安装:

java -version

下载并解压 Hadoop

下载 Hadoop

从 Apache 官方镜像下载稳定版(以 3.4.1 为例):https://downloads.apache.org/hadoop/common/hadoop-3.4.1/hadoop-3.4.1.tar.gz解压并重命名

sudo tar -zxvf hadoop-3.4.1.tar.gz -C /opt/ sudo mv /opt/hadoop-3.4.1 /opt/hadoop

配置 Hadoop

编辑 Hadoop 环境配置:

hadoop-env.sh

在/opt/hadoop/etc/hadoop/hadoop-env.sh中设置:export JAVA_HOME=/opt/jdk/jdk-11.0.19 export HADOOP_HOME=/opt/hadoopcore-site.xml

/opt/hadoop/etc/hadoop/core-site.xml:<configuration> <property> <name>fs.defaultFS</name> <value>hdfs://localhost:9000</value> </property> </configuration>hdfs-site.xml

/opt/hadoop/etc/hadoop/hdfs-site.xml:<configuration> <property> <name>dfs.replication</name> <value>1</value> </property> </configuration>设置免密 SSH(伪分布式必备)

ssh-keygen -t rsa -P '' -f ~/.ssh/id_rsa cat ~/.ssh/id_rsa.pub >> ~/.ssh/authorized_keys chmod 600 ~/.ssh/authorized_keys ssh localhost # 测试免密登录

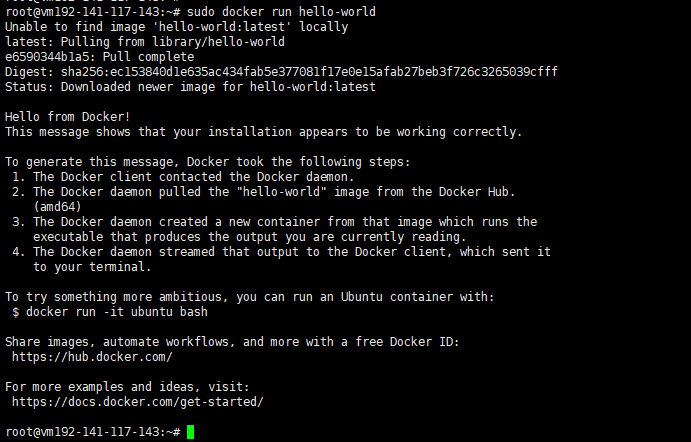

验证安装

格式化 NameNode

/opt/hadoop/bin/hdfs namenode -format启动 Hadoop

/opt/hadoop/sbin/start-dfs.sh /opt/hadoop/sbin/start-yarn.sh访问 Web 界面

- NameNode:http://localhost:9870

- ResourceManager:http://localhost:8088

运行示例 MapReduce

/opt/hadoop/bin/hadoop jar \ /opt/hadoop/share/hadoop/mapreduce/hadoop-mapreduce-examples-3.4.1.jar \ grep input output 'dfs[a-z.]+' /opt/hadoop/bin/hdfs dfs -cat output/*

外部资源与延伸阅读

- Apache 官方单节点集群搭建指南:

https://hadoop.apache.org/docs/stable/hadoop-project-dist/hadoop-common/SingleCluster.html ([hadoop.apache.org][1]) - JDK 下载与文档:

https://www.oracle.com/java/technologies/javase-downloads.html - CSDN Hadoop 环境搭建参考:

https://blog.csdn.net/qq_41946216/article/details/148997844

结语:

今天,你已经完成了从 JDK 安装到 Hadoop 单机伪分布式集群搭建的全流程。希望本文对你的大数据学习之路有所帮助,祝你早日玩转 Hadoop!

正文到此结束

- 本文标签: Hadoop环境搭建 安装JDK Java开发

- 本文链接: https://code.itptg.com/article/64

- 版权声明: 本文由老魏原创发布,转载请遵循《署名-非商业性使用-相同方式共享 4.0 国际 (CC BY-NC-SA 4.0)》许可协议授权